自动驾驶入门技术(4)—— 摄像头

时间:2022-12-17 08:30:00

1.车载摄像头基础分析

1.1 工作原理

目标对象通过镜头(LENS)将光学图像投射到图像传感器上,将光信号转换为电信号,然后通过A/D(模数转换)变成数字图像信号,最后发送到DSP在(数字信号处理芯片)中进行处理DSP将信号处理成特定格式的图像传输到显示屏上进行显示。

1.2 相机的主要硬件组件

1)镜头组(lens)- 镜头组由光学镜片、滤光片和保护膜等组成;

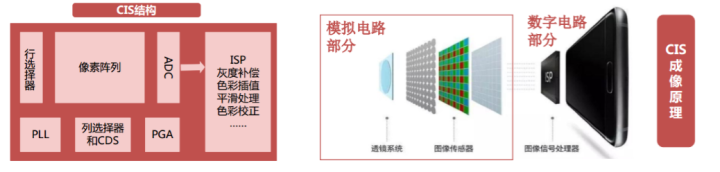

2) 图像传感器 - CMOS感光元件

MOS图像传感器(CIS)它是模拟电路和数字电路的集成。主要由微透镜和彩色滤光片组成(CF)、光电二极管(PD)、像素设计;

图1. CIS结构和CIS成像原理

3) DSP(数字信号处理芯片)

注:镜头组,CMOS芯片和胶合材料组装成模块

图2. 相机硬件组成

1.3 基本工作流程

工作流程: 图像输入 — 预处理 — 特征提取 — 特征分类 — 匹配 — 完成识别

即输入摄像头数据,根据每帧信息进行检测、分类、分割等计算,最后利用多帧信息进行目标跟踪,输出相关结果;

1)预处理包括帧、色调、白平衡、对比度平衡、图像矫正等。

2)在预处理的基础上提取特征提取图像中的特征;

3)目标识别是基于特征数据的输出来识别和分类图像中的物体 —— 人 ,车 、机器学习、神经网络等算法应用于交通标志等。

1.4 车载摄像头类别

1.4.1 根据相机的安装位置,可分为前视、侧视、后视和内置

1.4.2 根据功能应用,车载摄像头可分为三部分:驾驶辅助、驻车辅助和车内驾驶员监控

1)行车辅助类:行车记录仪、车道偏离预警、开门预警, 盲区监测、交通标志识别等

a、智能前视(单目/双目/三目):动态物体检测(车辆、行人)、静态物体检测(交通信号灯、交通标志、车道线等) 可通过空间划分等。

b、侧视辅助(广角):在驾驶过程中监测后视镜盲区的动态目标;

c、夜视辅助(夜视摄像头):根据工作原理,夜视系统主要分为三类:微光夜视技术、被动热成像夜视技术、主动红外夜视技术。

图3. 驾驶辅助摄像头

2)驻车辅助:倒车影像/360环视

360环视(广角/鱼眼):主要用于低速近距离感知;系统同时收集车辆周围的图像,通过图像处理单元畸变恢复→视角转化→图像拼接→图像增强最终在车辆周围形成无缝隙 360 全景俯视图。

图4. 图像输出效果示意图

3)车内驾驶员监控(疲劳检测)

a、驾驶员监控系统功能定义:

主要针对驾驶员疲劳、分心、不规范驾驶等危险情况进行一层或多层预警,要求在所有工作条件下(包括暗光、夜间、背光等)工作,不受驾驶员衣着的影响;

b、功能算法

DMS基于深度学习的视觉算法,以伟世通为基础AllGoEmbedded以系统为例,其DMS基本流程如下:

图5. 司机疲劳检测

面部检测:通过训练深度神经网络,将其归类为物体识别和分类问题,设计出鲁棒性好的面部检测器。

头部特征:由三个姿势角组成CNN以图像中的面部区域为输入,以三维姿态为输出,设计头部跟踪系统。

眼部检测:综合眼部检测网络和头部姿势角输出。

眨眼检测:包括眨眼信息(速度和时差)和眼部信息(开合)。眼部信息是一个二分类问题,需要一个小的神经网络;眨眼信息需要分析过去的帧。

2.比较单目和双目测距原理

2.1 单目摄像头

1)单目摄像头的工作过程也遵循图像输入、预处理、特征提取、特征分类、匹配和识别步骤。测距原理是先匹配识别后估算距离:通过图像匹配识别目标类别,然后根据图像大小估算距离;

2)单目测距算法包括传统机器学习算法和深度学习中的卷积神经网络(CNN)算法;

a、传统算法

在传统的机器学习算法中,通过图像特征描述子SIFT、SURF、BRIEF提取和匹配特征点,有许多可用的特征,包括角点、边缘点、暗点和亮点;

图6. 传统算法工作流程示意图

b、算法的深度学习

CNN主要针对图像处理。基本原理是通过多层过滤获得越来越抽象的图像特征。每个滤波器(由卷积核组成)学习并提取特征值,无需人工设计参数;

图7. 算法工作流程的深度学习

两种算法的本质区别在于手动提取和机器学习。因此,传统算法提取效率较低,鲁棒性低于深度学习算法;

2.2 双目摄像头

双目摄像头的测距原理与人眼相似。通过计算图像视差,直接测量前景的距离;从视差的大小推出物体的距离。视差越大,距离越近;

双目测距步骤:相机校准 —— 双目校正 —— 双目匹配 —— 计算深度信息(测距)

1)相机标定

由于光学透镜的特性,摄像头存在径向畸变;由于装配误差,传感器与光学镜头不完全平行,导致切向畸变;双目摄像头不仅需要获得每个摄像头的内部参数,还需要测量两个摄像头之间的相对位置(即右摄像头相对于左摄像头的旋转矩阵)R、平移向量t)。

2)双目校正

双目校正是根据单目内参数据(焦距、成像原点、畸变系数)和双目相对位置关系(旋转矩阵和平移向量)对左右视图进行消除畸变和对齐,使左右视图的成像原点坐标一致,两个摄像头光轴平行,左右成像平面共面,极线对齐。

3)双目匹配

双眼匹配的作用是匹配左右视图上相应的像点,以获得视差图。双眼匹配通常被认为是三维视觉中最困难和最关键的问题。

4)计算深度信息

如下图所示,P在待测物体上的某一点,OR与OT它们是两个相机的光心,点P在两个相机传感器上的成像点是P和P(相机的成像平面旋转后放在镜头前),f为相机焦距,B两相机中心距,Z为深度信息设点P到点P’的距离为dis,则:

三角形原理相似:

可得:

(在公式中,焦距f和摄像头中心距B可以通过校准获得,因此只需获得XR-XT(即视差d)深度信息可以通过值获得;)

图8. 双目测距原理示意图

2.3 分析单/双目方案的优缺点

1)单目相机

优点:成本低,计算资源要求低,系统结构相对简单;

缺点/难点:(1)需要不断更新和维护庞大的样本数据库,以确保系统达到较高的识别率;(2)无法判断非标准障碍物;(3)距离不是真正的测量,精度低。

2)双目相机

优点:(1)识别率没有限制,因为原则上不需要先识别再计算;(2)直接利用视差计算距离,精度高于单目;(3)不需要维护样本数据库,因为双目没有样本的概念。

缺点/难点:(1)计算量很大,对计算单元的性能要求很高,使得双目系统更难产品化、小型化。(2)双目视觉系统通过估计视差来测量距离,视差是通过立体匹配算法获得的。立体匹配是计算机视觉的典型问题;(3)双目在线校准比单目在线校准更复杂,因为双目匹配为1-D搜索,所以需要通过stereo rectification平行两个镜头的光轴,垂直于基线。

3 、规级摄像头的性能要求

1、耐高温 :车载摄像头-40℃~85℃范围内都能正常工作,且能适应温度的剧烈变化;

2.抗震:车辆在不平坦的道路上行驶时会产生强烈的振动,因此车载摄像头必须能够抵抗各种强度的振动;

3、防磁 : 车辆启动时会产生极高的电磁脉冲,需要极高的防磁性能;

4、防水 : 装载摄像头的密封应非常紧密,在雨水中浸泡几天后仍能正常使用;

5、使用寿命 : 使用寿命至少为8~10年才能满足要求;

6、超广角: 侧视环视摄像头必须是超广角,水平视角达到 135°;

7、高动态: 车辆行驶速度快,摄像头面临的光环境变化剧烈频繁,需要摄像头CMOS 高动态特性;

8、低噪点: 当光线较暗时,能有效抑制噪声,特别是侧视和后视摄像头即使在晚上也能清晰地捕捉到图像。

图9. 车载摄像头工艺流程

4、车载摄像头的内外参标定

机标定的目标就是为了获得相机的内参数和相机的外参数;

4.1 内参标定

1)内参矩阵(Sx,Sy,Cx,Cy,f):代表相机的内部结构参数

参数说明:Sx和Sy代表相机芯片单个像素的物理尺寸Sx = 1/dx, Sy = 1/dy,单位是像素/毫米,一般情况下Sx=Sy,除非单个像素点在成像仪上是矩形而不是正方形。 Cx和Cy分别代表相机芯片的中心可能的偏移,这是因为芯片的安装通常无法绝对精准。 f代表相机的焦距,fx = f * Sx,fy=f * Sy。

2)畸变参数:k1,k2,k3径向畸变系数,p1,p2是切向畸变系数。(五个畸变参数,一般只需计算出k1,k2,p1,p2;对于鱼眼摄像头等径向畸变特别大的才需要计算出k3。)径向畸变发生在相机坐标系转图像物理坐标系的过程中;而切向畸变是发生在相机制作过程,其是由于感光元平面跟透镜不平行。

a、径向畸变:产生原因是光线在远离透镜中心的地方比靠近中心的地方更加弯曲,径向畸变主要包含桶形畸变和枕形畸变两种。

b、切向畸变:产生的原因透镜不完全平行于图像平面,这种现象发生于成像仪被粘贴在摄像机的时候。

3)内参的标定方式主要可以归为三类:传统的标定方法、基于主动视觉的标点以及自标定;目前常用的标定方法还是传统标定方法,比如张氏标定。

4.2 外参标定

相机外参数是相机的旋转矩阵R和平移向量t;旋转矩阵和平移矩阵共同描述了如何把点从世界坐标系转换到摄像机坐标系;

1)旋转矩阵:描述世界坐标系->相机坐标系的旋转变换

2)平移矩阵:描述世界坐标系->相机坐标系的平移变换

世界坐标系(world coordinate),也称为测量坐标系,是一个三维直角坐标系,以其为基准可以描述相机和待测物体的空间位置。世界坐标系的位置可以根据实际情况自由确定。

相机坐标系(camera coordinate),也是一个三维直角坐标系,原点位于镜头光心处,x、y轴分别与相面的两边平行,z轴为镜头光轴,与像平面垂直。

5、感知模块中摄像机的技术特点解析

5 .1 优势分析

1)相比于毫米波雷达,目前摄像头的主要优势在于:

a、目标识别与分类 - 目前普通的3D毫米波雷达仅可以检测到前方是否有障碍物,而无法精准识别障碍物的大小和类别;例如:各类车道线识别、红绿灯识别以及交通标志识别等;

b、可通行空间检测(FreeSpace) - 对车辆行驶的安全边界(可行驶区域)进行划分,主要对车辆、普通路边沿、侧石边沿、没有障碍物可见的边界、未知边界进行划分;

c、对横向移动目标的探测能力 ,比如对十字路口横穿的行人以及车辆的探测和追踪;

d、定位与地图创建 - 即视觉SLAM技术,虽然目前也有用毫米波雷达做SLAM的,不过视觉SLAM技术更加成熟,也更有应用前景;

2)在自动驾驶系统中,激光雷达与摄像头感知作用比较类似,但相比激光雷达,其优势为:

a、红绿灯识别及交通标示识别

b、成本优势,且算法及技术成熟度比较高

c、物体识别率高

5.2 劣势分析

1)受天气、光照变化影响大,极端恶劣天气下视觉传感器会失效;

2)测距/测速性能不如激光雷达和毫米波雷达;

6、车载智能前视像头(单目/双目)关键参数

1)探测距离

2)水平视场角

3)垂直视场角

4)分辨率

当摄像机摄取等间隔排列的黑白相间条纹时,在监视器(比摄像机的分辨率要高)上能够看到的最多线数,当超过这一线数时,屏幕上就只能看到灰蒙蒙的一片,而不再能分辨出黑白相间的线条。

5)最低照度

最低照度,即图像传感器对环境光线的敏感程度,或者说是图像传感器正常成像时所需要的最暗光线。它是当被摄物体的光照逐渐降低时,摄像机的视频信号电平低于标准信号最大幅值一半时的景物光照度值。

6)信噪比

输出信号电压与同时输出的噪声电压的比值;

7)动态范围

摄像机拍摄的同一个画面内,能正常显示细节的最亮和最暗物体的亮度值所包含的那个区间。动态范围越大,过亮或过暗的物体在同一个画面中都能正常显示的程度也就越大。

注:文章首发于公众号“筋斗云与自动驾驶”,扫描下方二维码关注公众号并在主页面点击左下角“福利”,有40余篇自动驾驶与EE架构相关国外参考技术文献赠送。

筋斗云与自动驾驶