【时序】TCCT:用于时间序列预测的紧耦合卷积 Transformer

时间:2023-03-05 03:00:00

论文名称:TCCT: Tightly-coupled convolutional transformer on time series forecasting

论文下载:https://doi.org/10.1016/j.neucom.2022.01.039

论文年份:2021

1(2022/05/01)

论文代码:https://github.com/OrigamiSL/TCCT2021

论文总结

TCCT:时间序列预测的紧耦合卷积 Transformer

紧耦合、松耦合是什么?

松耦合:模型只使用常用 CNN 例如,应用标准卷积层和最大池化层 Transformer,或以其他方式顺序或并行堆叠 CNN 块和 Transformer 块。松耦法在一定程度上得到了改进 Transformer 性能模型。

紧耦:只有在 Transformer 模型中应用具体变换后 CNN 架构,才能将 Transformer 和 CNN 紧密结合,充分发挥其优势。

本文的解决方案 TCCT?

其基于 Informer 和 LogSparseTransformer,这两篇论文在之前的博这两篇论文。然后再融合 CSPNet,TCN 扩张因果卷积 和 Yolov两种直通机制。其中,CSPNet 在此基础上提出 CSPAttention,降低内存复杂性,提高预测精度;扩展因果卷积用于增加指数的感觉野;直通机制取代 Informer 原蒸馏机制。提高计算效率,降低内存复杂性。

Abstract

Time series forecasting is essential for a wide range of real-world applications. Recent studies have shown the superiority of Transformer in dealing with such problems, especially long sequence time series input (LSTI) and long sequence time series forecasting (LSTF) problems. To improve the efficiency and enhance the locality of Transformer, these studies combine Transformer with CNN in varying degrees. However, their combinations are loosely-coupled and do not make full use of CNN. To address this issue, we propose the concept of tightly-coupled convolutional Transformer (TCCT) and three TCCT architectures which apply transformed CNN architectures into Transformer: (1) CSPAttention: through fusing CSPNet with self-attention mechanism, the computation cost of self-attention mechanism is reduced by 30% and the memory usage is reduced by 50% while achieving equivalent or beyond prediction accuracy. (2) Dilated causal convolution: this method is to modify the distilling operation proposed by Informer through replacing canonical convolutional layers with dilated causal convolutional layers to gain exponentially receptive field growth. (3) Passthrough mechanism: the application of passthrough mechanism to stack of self-attention blocks helps Transformer-like models get more fine-grained information with negligible extra computation costs. Our experiments on real-world datasets show that our TCCT architectures could greatly improve the performance of existing state-of-the-art Transformer models on time series forecasting with much lower computation and memory costs, including canonical Transformer, LogTrans and Informer.

时间序列预测对于广泛的实际应用至关重要。最近的研究表明,Transformer 特别是在处理这些问题方面具有优势输入长序列时间序列(LSTI)预测长序列时间序列(LSTF)问题。为了提高 Transformer 这些研究将提高效率和局部性 Transformer 与 CNN 不同程度的结合。但是,它们的组合是松耦合没有得到充分利用 CNN。为了解决这个问题,我们提出了这个问题卷积变换器紧密耦合(TCCT)的概念和三个将变换后的 CNN 架构应用到 Transformer 中的 TCCT 架构:

-

1)CSPAttention:通过将 CSPNet 结合自注意机制,降低自注意机制的计算成本 内存使用减少30% 50%同时达到或超过预测精度。

-

2)因果卷积的扩张(Dilated causal convolution):这种方法是通过的用扩张因果卷积层代替规范卷积层进行修改Informer为了获得指数感受野生增长,提出了蒸馏操作。

-

3)直通机制(Passthrough mechanism):将直通机制应用于自注意力块堆栈 Transformer 获得更细粒度信息的模型(fine-grained information),额外的计算成本可以忽略不计。

我们在真实世界数据集中的实验表明,我们 TCCT 现有最先进的架构可以大大提高 Transformer 在时间序列预测中,模型的性能降低了计算和内存成本,包括规范 Transformer,LogTrans 和 Informer。

1. Introduction

时间序列预测股市预测 [1]事件驱动的情绪分析 [2]工业资产监测 [3]卫星图像分类 [4] 许多其他领域都发挥着重要作用。在大数据时代,时间序列预测模型开始面临预测长度越来越长所以场景对于每个滚动窗口,模型也应该能够处理更多的过去信息。为了满足长期预测的需要,包括 ARIMA [5,6] 和 SSM [7] 在内的由于其具体模型需要人工选择来考虑各种相关因素,传统的时间序列预测模型的能力不足。

基于深度神经网络的模型是解决上述问题的好候选人,特别是 Transformer 模型 [8-11]。与 CNN [12-14] 或 RNN [15-17] 与时间序列预测模型相比,Transformer 自注意机制有助于模型在不受时间距离影响的情况下,在不受时间距离影响的情况下均匀使用输入的任何部分 Transformer 模型在处理远程信息和捕获长期依赖时更有潜力。但是,Transformer 自注机制也带来了成本和内存消耗增长是根据输入长度的二次方计算的。当模型堆叠几个自注意力块时,情况会变得更糟。由于自注机制中的逐点查询键匹配,Transformer 模型对局部上下文不敏感,使得模型在接收异常数据时不够强壮。

为了提高Transformer架构的效率和增强局部性,最近提出了很多研究与CNN相结合的类Transformer模型解决了各种任务,包括时间序列预测。局部特征提取的特征使 CNN [18,19] 与 Transformer 互补。但是,现有的相关模型大多是松耦合的(Loosely-coupled)卷积 Transformer。这里的松耦合意味着模型只会常用 CNN 例如,应用标准卷积层和最大池化层 Transformer,或以其他方式顺序或并行堆叠 CNN 块和 Transformer 块。

-

LogTrans [10] 线性投影用因果卷积层代替查询、键和值。 Informer [11] 使用标准卷积层和最大标准卷积层化层来连接自注意力块。

-

DS-Net [20] 分别使用基于 CNN 的网络和基于 Transformer 的网络生成特征图。

-

TransCNN [21] 将池化层应用于自注意力机制,并将自注意力块与由深度卷积层和最大池化层组成的 TDB 和 IRB 块连接起来。由于使用了 CNN 架构,TransCNN 已经在“松耦合”方法和“紧耦合”方法之间达到了某种程度。然而,其在自注意力机制内部的 CNN 应用仍然仅限于常见的池化层。

毫无疑问,“松耦合”方法在一定程度上提高了 Transformer 模型的性能。然而,只有“紧耦合”方法,即在 Transformer 模型中应用特定的变换后的 CNN 架构,才能将 Transformer 和 CNN 紧密结合,从而充分发挥它们的优势。因此,在本文中,我们试图回答这个问题:特定的 CNN 架构是否可以应用在 Transformer 模型中,以增强其学习能力并增强其局部性,同时提高其效率?

为此,我们的工作深入研究了 Transformer 和 CNN 的紧密结合。在我们的工作中,转换后的三个经典 CNN 架构已成功应用于时间序列预测的 Transformer 模型。本文的贡献可以总结如下:

- 我们提出了紧耦合卷积Transformer (TCCT) 和三种 TCCT 架构的想法。转换后,这些架构不仅增强了 Transformer 的局部性,“松耦合”方法也可以做到这一点,而且增强了 Transformer 的学习能力,降低了计算成本和内存使用。它们也足够通用,可以处理其他类似 Transformer 的时间序列预测模型。

- 我们提出了 CSPAttention,一种镜像 CSPNet 的自注意力机制,属于CNN。它减少了近 30% 的内存占用和 50% 的 self-attention 机制的时间复杂度,同时实现了同等或更高的预测精度。

- 我们提出了改进的自注意力蒸馏操作,采用扩张因果卷积代替规范卷积来连接自注意力块。它帮助 Transformer 模型以更小的计算成本获得指数感受野增长。因此,Transformer 的学习能力得到了加强。

- 我们提出了直通机制(passthrough mechanism)来连接不同尺度的自注意力块的特征图,从而获得更细粒度的信息。与 CNN 和图像处理中常用的特征金字塔类似,它扩展了特征图,从而提高了 Transformer 模型的预测性能。

2. Related works

2.1. Time series forecasting

由于时间序列预测在许多领域的广泛存在,人们提出了各种方法来解决时间序列预测问题。传统的时间序列预测方法主要基于统计数据,通常具有理论保证和较强的可解释性[5-7,22]。还存在受机器学习算法启发的方法,例如支持向量机 [1] 和分层贝叶斯方法 [23]。由于近来传统方法无法处理和预测长序列多元时间序列的需求,基于深度学习的方法逐渐成为主流。流行的基于深度学习的方法主要基于 RNN [17,24–26]。与传统模型相比,它们取得了更好的性能,尤其是在处理多变量时间序列预测问题时,但在面对长序列时间序列输入(long sequence time series input,LSTI)或长序列时间序列预测( long sequence time series forecasting ,LSTF)问题时仍然不够好。为了寻找和建立输出和输入之间的长程依赖关系,从而解决 LSTI 和 LSTF 问题,Transformer 是一个不错的选择,这要归功于它的自注意力机制。

2.2. Transformer models on time series forecasting

近年来已经提出了几种 Transformer 模型来解决时间序列预测问题。它们主要来自 Vaswani Transformer [27],基本上没有什么变化 [9,28,29]。 LogTrans 和 Informer 是与我们的工作最相关的两个工作,因为它们致力于将 CNN 和 Transformer 结合起来。 LogTrans 用卷积层代替了自注意力机制的线性投影,Informer 使用卷积层和最大池化层来连接自注意力块,这意味着它们都是松散耦合的卷积 Transformer 模型。这是我们的工作旨在解决的主要限制。然而,不可否认它们是最先进的,因此,我们的实验主要基于这两个基线来检查我们三个 TCCT 架构的效果,并将它们升级为紧耦合卷积 Transformer 模型,特别是更具竞争力的 Informer。

2.3. Related CNN

卷积神经网络 [18,30–32] 在处理计算机视觉问题时具有举足轻重的地位。在这么多伟大的作品中,我们想强调两个与我们的工作密切相关的 CNN 架构,CSPNet [33] 和 Yolo 系列网络 [34-36]。尽管计算机视觉和时间序列预测是完全不同的任务,但可以借鉴这两种 CNN 架构的一些好主意。 Cross Stage Partial Network (CSPNet) 旨在缓解复杂 CNN 架构的计算瓶颈,以处理繁重的计算机视觉任务。 CSPNet通过在阶段开始分离特征图,然后将部分特征图直接链接到阶段结束并最后将它们全部整合来缓解重复梯度信息的问题。在我们的论文中,类似的概念也应用于自注意力机制。 Yolo 系列卷积网络是非常著名的实时目标检测器。即使是现在,最先进的基于 Yolo 或与 Yolo 相关的对象检测器也不断被提出,例如 PP-YOLOv2 [37]、YOLOS [38] 等。而不是将整个 Yolo 基线应用到 Transformer 架构中,我们只是借用了 Yolo9000 [34] 中首次提出的直通机制(passthrough mechanism)的思想,并将其应用于 Transformer 编码器内的自注意力块堆栈。除了计算机视觉,CNN还在时间序列预测任务中占有一席之地,例如Wavenet [13]、TCN [12]、Seq-U-net [14]等。这些网络的核心思想是使用因果关系卷积层及其后代形式。在我们的工作中,我们从时间卷积网络 (TCN) 中借用扩张因果卷积的概念来连接自我注意块,以获得指数级的感受野增长并增强 Transformer 的局部性。

3. Preliminary

3.1. Problem definition

在介绍 Methodology 之前,我们首先提供时间序列预测问题的定义。假设我们有一个固定的输入窗口 { z i , 1 : t 0 } i = 1 N \{z_{i,1:t_0}\}^N_{i=1} { zi,1:t0}i=1N,任务是预测对应的固定目标窗口 { z i , t 0 + 1 : t 0 + T } i = 1 N \{z_{i,t_0+1:t_0+T}\}^N_{i=1} { zi,t0+1:t0+T}i=1N。 N 是指相关单变量时间序列的数量,t0 是输入窗口大小,T 是预测窗口大小。给定一个长度远大于预设输出窗口大小的长目标序列,采用滚动预测策略对整个序列进行预测。

3.2. Informer architecture

Informer 是从规范 Transformer [27] 派生的时间序列预测模型。 Informer 进行了多项改进,以增强类 Transformer 模型在长序列时间序列预测 (LSTF) 问题中的预测能力。由于其最先进的性能,我们将其用作主要基线并将我们的 TCCT 架构应用于它。我们将简要介绍其与规范 Transformer 的主要变化,并请读者参考 [11] 了解更多详细信息。总结了四点。

A. Informer 的编码器不是典型的自注意力机制,而是包含 ProbSparse 自注意力机制。 ProbSparse self-attention 允许每个 key 在执行缩放的点积时只关注主导查询(dominant querie)以提高效率。判断主导查询的方法是通过 查询-键 注意力概率分布的 Kullback-Leibler 散度和均匀分布。拥有较大 KL 散度的查询被视为更具优势的查询。由于 self-attention 分数的长尾分布,ProbSparse self-attention 只需要计算 O(lnLQ) 点积,而不是规范 self-attention 中的 O(LQ)。

B. 除此之外,self-attention 的蒸馏操作是在 Informer 的编码器中进行的。卷积层和最大池化层用于连接自注意力块,并将前一个自注意力块的输出下采样到其半片中。这样,在堆叠 k 个 self-attention 块时,编码器最终输出的长度将是输入长度的 1 / 2 k − 1 1/2^{k-1} 1/2k−1。

C. 为了增强鲁棒性,Informer 也可以包含 k-1 个额外的编码器,其输入长度和自注意力块的数量逐渐减少。第 i 个额外的编码器堆叠 k-i 个自注意力块,它的输入是主编码器输入的最后 1 / 2 i 1/2^i 1/2i,因此所有编码器的输出长度相同。我们将这种替代方法称为完全蒸馏操作以供后续使用。

D. 除了上述变化外,Informer 还包含一个生成式推理解码器,通过一个前向过程预测输出。解码器的输入向量由两部分组成,起始标记(token)和目标序列。解码器的掩码自注意力机制被掩码 ProbSparse 自注意力机制所取代。

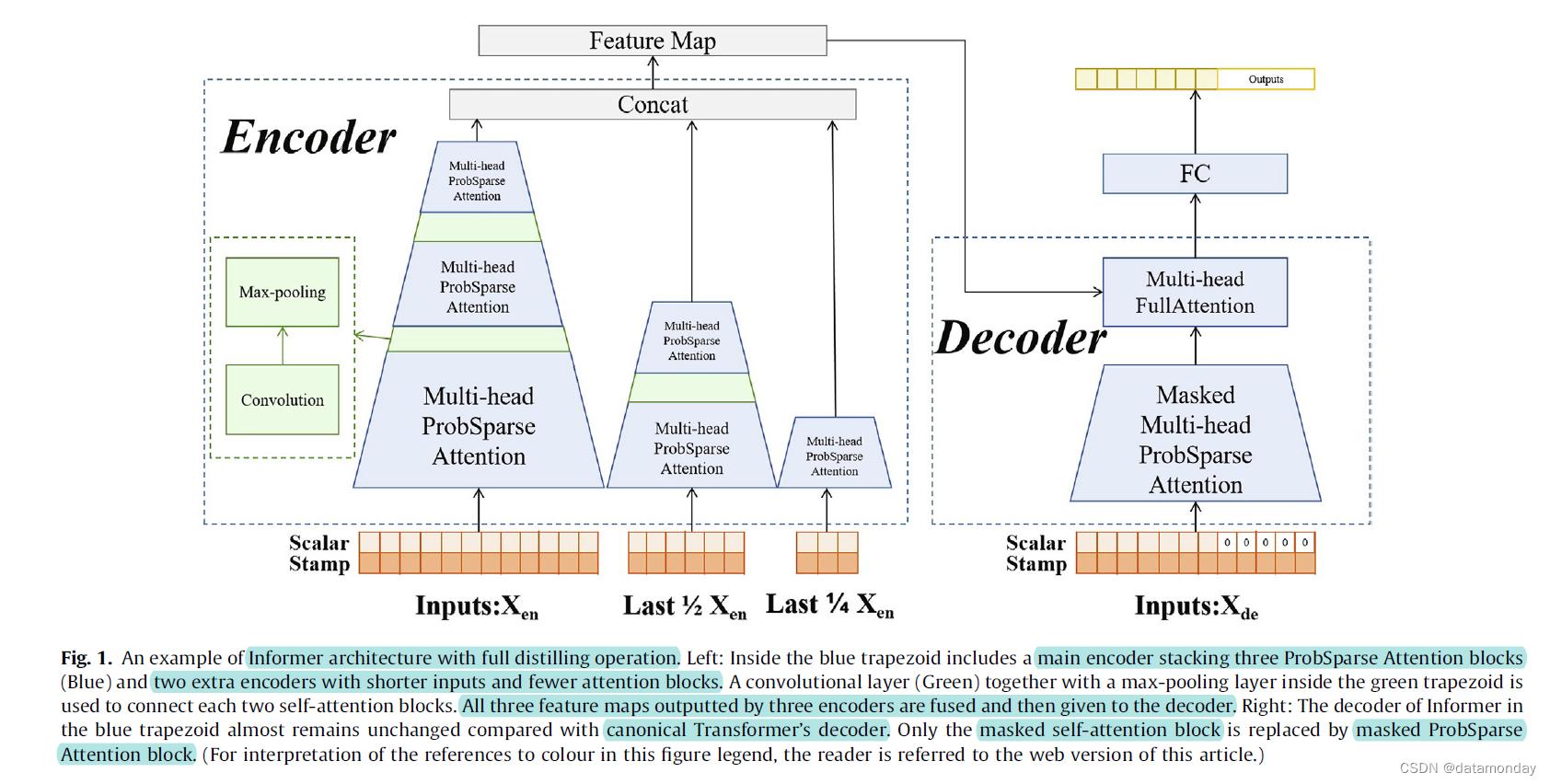

具有完全蒸馏操作(distilling operation)和 3 层主编码器的 Informer 的总体架构如图 1 所示。

图 1. 具有完全蒸馏操作的 Informer 架构示例。左:蓝色梯形内部包括一个主编码器,堆叠了三个 ProbSparse Attention 块(蓝色)和两个额外的编码器,输入更短,注意力块更少。绿色梯形内的卷积层(绿色)和最大池化层用于连接每两个自注意力块。三个编码器输出的三个特征图全部融合,然后交给解码器。右图:蓝色梯形中 Informer 的解码器与标准 Transformer 的解码器相比几乎没有变化。只有被掩蔽的自注意力块被掩蔽的 ProbSparse Attention 块替换。有关此图例中颜色参考的解释,请读者参考本文的网络版本。

4. Methodology

我们首先依次介绍三种紧耦合卷积变换器(TCCT)架构:CSPAttention、扩张因果卷积和直通机制。然后将展示将 TCCT 架构与类似 Transformer 的时间序列预测模型相结合的方法。

4.1. CSPAttention

图 2. CSPAttention 块。输入(蓝色)分为两部分。第一个(绿色)通过 A 层传播,一个 1×1 卷积层,而另一个(红色)通过块 B 传播,一个自注意力块。最后将两个部分的输出连接在一起,作为整个 CSPAttention 块的最终输出。

我们提出的 CSPAttention 的一个块的架构如图 2 所示**。输入 R L × d R^{L \times d} RL×d,其中 L L L 是输入长度, d d d 是输入维度,通过维度 X = [ X 1 L × d 1 , X 2 L × d 2 ] X = [X^{L \times d_1}_1, X^{L \times d_2}_2] X=[X1L×d1,X2L×d2] 分为两部分。 X 1 X_1 X1 在经过一个 1×1 卷积层 A 后链接到块的末端,而 X 2 X_2 X2 充当self-attention block B 的输入。A 和 B 的输出通过维度连接起来作为整个block的输出**。

排除偏差,CSPAttention 的一个阶段的输出矩阵由下式给出

受 CSPNet [33] 的启发,CSPAttention 处理标记维度的方式反映了 CSPNet 处理图像通道的方式。整个输出 Y 可以写成一个子块矩阵,这样分割的两部分不包含属于另一部分的重复梯度信息。此外,为了在整个输出维度不等于整个输入维度时,将第一部分投影到合适的维度,我们添加了一个额外的 1 × 1个卷积层。 CSPAttention 的权重更新如下图所示:

其中 f 是权重更新函数,g 表示传播到第 i 条路径的梯度。可以看出,分割部分的梯度是分别积分的。

设计 CSPAttention 的目的是为了缓解self-attention机制的内存瓶颈和计算效率问题。CSPNet 已经展示了它在提高性能和减少基于 CNN 架构的计算方面的能力。我们的 CSPAttention 还降低了自注意力机制的内存流量和时间复杂度。假设一个规范的自注意力块的输入和输出维度都是 d 并且只有一个输入标记。如图 3(a) 所示,一个自注意力块包含四个线性投影层,其输入和输出维度均为 d(查询、键、值、投影)。因此,内存占用为 4 d 2 4d^2 4d2。然而,假设 CSPAttention 将输入维度分成两半,CSPAttention 的第一部分只有一个线性投影层,而第二部分有四个。相应的架构如图 3(b) 所示。因此,一个 CSPAttention 块的内存占用是 ( 4 + 1 ) × ( d / 2 ) 2 (4 + 1) \times (d/2)^2 (4+1)×(d/2)2,是典型自注意力块的 31.25%。

定理1。假设 CSPAttention 将输入维度分成两半,与规范的 self-attention 块相比,它至少减少了 50% 的时间复杂度。

证明推迟到附录 A。定理 1 意味着 CSPAttention 不仅减少了内存占用,而且还降低了相当大的时间复杂度。

CSPAttention 还可以应对其他类似 Transformer 的架构,并将它们升级为紧耦合卷积 Transformer 架构。我们以 LogTrans [10] 为例,组合架构——LogSparse CSPAttention 块如图 4 所示。LogTrans 的优化集中在缩放点积期间的查询长度,而 CSPAttention 的优化输入。它们相互独立,因此在图 4 中,LogSparse 自注意力可以直接替代图 2 中的规范自注意力。同样,当将 CSPAttention 应用于 Informer 时,ProbSparse 自注意力将升级为 ProbSparse CSPAttention。更重要的是,与 CSPNet 类似,CSPAttention 增加了梯度路径的数量,确保模型能够以更少的计算和内存使用实现同等或更高的预测精度。

4.2. Dilated causal convolution

堆叠多个自注意力块有利于提取更深的特征图,但是会带来更多的时间和空间复杂度。为了进一步减少内存使用,Informer 使用了 self-attention distilling 操作。 Informer 在每两个自注意力块之间使用一个卷积层和一个最大池化层来修剪输入长度。步长为 1 的内核大小为 3 的卷积层遵循前一个自注意块,以使特征更加了解局部上下文信息。然后使用步长为 2 的内核 3 的最大池化层来赋予局部主导特征(local dominating features)的特权,并为后一个自注意力块提供一个较少但更集中的特征图。堆叠三个自注意力块的网络如图 5 所示。为简单起见,我们仅显示最后一个输入元素的感受野。

然而,规范(canonical,也就是一般的卷积层)卷积层在应用于时间序列预测时有两个主要缺点。首先,它只能随着网络深度的增长而回顾线性大小的历史。因此,即使 Informer 旨在处理长序列时间序列预测问题,它在处理极长序列方面也不够强大。随着计算成本的增长,将 self-attention blocks 与 canonical convolutional layers 堆叠在一起并不能带来足够的好处,相反,由于感受野有限,可能会导致重复和无意义的计算。此外,规范卷积层没有考虑时间视角,这将不可避免地导致时间序列预测中未来的信息泄漏。

我们的解决方案受 TCN [12] 的启发,用扩张的因果卷积(dilated causal convolution)代替了规范卷积,以获得指数感受野(receptive field)的增长。更正式地说,对于第 i 个自注意力块之后的第 i 个卷积层,序列 X ∈ R L × d X \in \R^{L \times d} X∈RL×d 的元素 x n ∈ R d x_n \in \R^d xn∈Rd 上的内核大小为 k k k 的扩张因果卷积运算 C C C 定义为:

d’ 是输出维度,这里的数字 i 也用作膨胀因子。第 i 个扩张的因果卷积层的过滤器在两个相邻的过滤器抽头(filter taps)之间跳过 ( 2 i − 1 − 1 2^{i-1}-1 2i−1−1) 个元素。此外,由于因果关系的性质,序列的时间 t t t 处的每个元素 x x x 仅与 t t t 处或之前的元素进行卷积,确保未来不会有信息泄漏。请注意,当 i = 1 i = 1 i=1 时,扩张的因果卷积会退化为正常的因果卷积。我们在图 6 中提供了一个堆叠三个自注意力块并使用内核 3 的扩张因果卷积层的网络的图示。

比较图 5 和图 6,可以清楚地看出,扩张因果卷积仅在时间前端使用填充(padding),防止未来信息的泄漏。即使只有两个卷积层,图 6 中网络的输出感受野也明显大于图 5。因此,堆叠更多的自注意块,差距会更大,因此,两个网络的表现会更好。除此之外,扩张因果卷积的应用只会带来少许的计算成本和内存使用(填充成本),可以忽略不计。

当与 CSPAttention 结合使用时,扩张的因果卷积层也可以作为一个过渡层,用于融合来自前 CSPAttention 块的两个部分的特征图。

4.3. Passthrough mechanism

特征金字塔(Feature pyramid)通常用于在计算机视觉和 CNN [40] 中提取特征。类似的概念可以应用于基于 Transformer 的网络。 Yolo 系列目标检测 CNN 网络 [34-36] 提出的直通机制(passthrough mechanism),从早期网络中获取特征图并将它们与最终特征图合并以获得更细粒度的信息。

我们使用它来合并基于 Transformer 的网络中不同尺度的特征图。假设一个编码器堆叠了 n 个自注意力块,那么每个自注意力块都会产生一个特征图。假设 CSPAttention 和扩张因果卷积已应用于该编码器,则第 k 个(k = 1,2. . .n)特征图的长度为 L / 2 k − 1 L/2^{k-1} L/2k−1,维度为 d d d。为了连接所有不同尺度的特征图,第 k 个特征图被等价地按长度分割成 2 n − k 2^{n-k} 2n−k 个长度为 L / 2 n − 1 L/2^{n-1} L/2n−1 的特征图。这样,所有的特征图都可以按维度连接起来。但是,连接的特征图的维度为 ( 2 n − 1 ) × d (2^n - 1) \times d (2n−1)×d,因此应采用过渡层来确保整个网络导出适当维度的特征图。我们提出了一个堆叠三个自注意力块的网络,并采用了上面提到的所有 TCCT 架构,如图 7 所示。

直通机制(passthrough mechanism)的作用类似于 Informer 的全蒸馏操作。但是,具有完全蒸馏操作的 Informer 需要的编码器数量与主编码器的自注意力块数量一样多,而具有直通机制的 Informer 只需要一个编码器。尽管具有完全蒸馏操作的 Informer 的编码器具有逐渐减小的输入长度,但它引起了模型对后期时序数据的更多关注。例如,假设 Informer 堆叠了 k 个编码器,则输入序列的前半部分仅存在于主编码器中,相反,输入序列的后 1 / 2 k − 1 1/2^{k-1} 1/2k−1 存在于每个单个编码器中。直通机制没有这样的不足。更重要的是,直通机制几乎没有给 Informer 带来额外的计算成本,而具有完全蒸馏操作的 Informer 由于其多编码器架构,会产生相当大的额外计算成本。

4.4. Transformer with TCCT architectures

以上所有架构都可以与 Transformer 或类 Transformer 的时间序列预测模型无缝协作,包括规范的 Transformer、LogTrans、Informer 等。与 Informer 协作的简单示例如图 8 所示,详细的编码器示例如图 9 所示。注意图 8 中的 Informer 只有一个编码器,这意味着它没有使用完全蒸馏操作,而是用直通机制代替了它。

在 Informer 架构的基础上,其他类似 Transformer 的基线可以轻松地与 TCCT 架构配合。例如,为了将 TCCT 架构与 LogTrans 相结合,图 8 中的(掩码)ProbSparse 自注意力块将被(掩码)LogSparse 自注意力块替换,其他架构保持不变。

5. Experiment

5.1. Datasets

我们主要在一个公共的真实世界 ETT1(电力Transformer温度)数据集上进行实验,该数据集由持续近 2 年的 ETT 数据组成。 ETT 数据集由四个子集组成:{ETTh1, ETTh2} 是来自中国两个独立县的 1 小时级数据集; {ETTm1, ETTm2} 是来自与 {ETTh1, ETTh2} 相同来源的 15 分钟级数据集。每个数据点由目标值“油温”和其他 6 个功率负载特征组成。在网络训练/验证/测试期间使用具有 Z 分数归一化的原始数据。我们主要选择 ETTh1 和 ETTm1 来评估模型。 train/val/test 默认为 12/4/4 个月。

ETT1 Dataset: https://github.com/zhouhaoyi/ETDataset

更具体地说,上面的数据集在时间上被均匀、连续和紧凑地分割。训练子集包含前 12 个月的数据,验证子集包含接下来 4 个月的数据,测试子集包含最后 4 个月的数据。数据集的更详细信息显示在附录 D 中。

5.2. Methods

我们选择 Informer 作为基本基线,并分别测试我们提出的 TCCT 架构应对它的效果。 Informer 通过实验展示了其最先进的性能,同时与许多其他时间序列预测的优秀作品相比,包括 ARIMA [41]、Prophet [42]、LSTMa [43] 等。广泛研究我们的 TCCT 架构可以在多大程度上改进 Informer。因此,选择了五种方法:

- Informer,只有一个编码器的基本 Informer

- Informer+,完全蒸馏操作的Informer

- TCCT_I,Informer 结合 CSPAttention

- TCCT_II,Informer 结合 CSPAttention 和扩张的因果卷积

- TCCT_III,Informer 与所有 TCCT 架构相结合。

在没有异常指令的情况下,Informer、TCCT_I、TCCT_II、TCCT_III 包含一个编码器堆叠 3 个自注意力块,而 Informer + 包含一个具有完全蒸馏操作的 3 编码器堆栈。此外,每个方法都包含一个 2 层解码器。

在这五种方法中,TCCT_I和TCCT_II主要与Informer进行比较,因为它们的单编码器架构。 TCCT_II 主要与 Informer+ 相比,因为它们的多编码器架构或具有类似功能的透传机制。此外,为了进一步研究我们提出的 TCCT 架构在增强其他 Transformer 或类似 Transformer 的模型在时间序列预测方面的适用性,我们选择了两种额外的方法,canonical Transformer 和 LogTrans,并研究我们的 TCCT 架构在以下情况下是否可以提高其性能。源代码位于 https://github.com/OrigamiSL/TCCT2021

5.3. Experiment details

进行了四组实验,以检查 TCCT 架构在时间序列预测方面为 Transformer 或类 Transformer 模型带来的预测准确性和效率的改进。选择 MSE 作为损失函数。所有方法都使用 Adam 优化器进行优化,学习率从 1e 到 4,每个 epoch 衰减两倍。解码器的起始令牌长度与编码器的输入长度保持一致。 epoch 总数为 6,并带有适当的提前停止。批量设置为 32。每个单个实验单独重复 10 次并取平均结果。所有实验均在单个 Nvidia GTX 1080Ti 12 GB GPU 上进行。进一步的具体细节在具体实验中显示。

5.4. Result and analysis

5.4.1. Ablation study on LSTF problem

在此设置下,将在单变量和多变量条件下评估五种方法的时间序列预测能力,从而说明三种 TCCT 架构分别提高 Informer 的预测准确度有多大。 ETTh1 和 ETTm1 数据集都用于检查。我们将编码器输入长度固定为 384,并在 {48, 96, 192, 384} 中逐步延长预测窗口大小。选择 MSE 和 MAE(多元预测的平均)来比较不同方法的预测精度。 n 是指预测窗口大小。如果需要,还选择这两个标准来评估以下实验中的预测准确性。我们在这组实验中专门通过相应的标准差 S = ∑ ( y − y ^ ) 2 n 2 S=\sqrt[2]{\frac{\sum(y-\hat{y})2}{n}} S=2n∑(y−y^)2