风格迁移篇--AdaAttN:重新审视任意神经风格转移中的注意机制

时间:2022-09-06 16:00:00

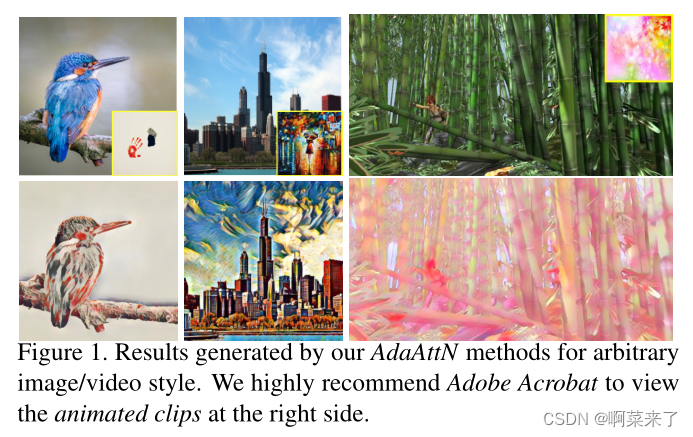

本文提出了一种新的注意力和归一化模块,称为自适应注意力归一化:AdaAttN,任意图像/视频风格迁移最先进,性能优于SANet、AdaIN等待网络,代码已开源。

作者:百度、南京大学、国防科技大学

paddle代码:https://github.com/PaddlePaddle/PaddleGAN

pytorch代码:https://github.com/Huage001/AdaAttN

论文:http://arxiv.org/abs/2108.03647

文章目录

- Abstract

- 1、Introduction

- 2、Related Works

-

- 2.1. Arbitrary Style Transfer

- 2.2. Video Style Transfer

- 3、Methods

-

- 3.1. Overall Framework

- 3.2. Adaptive Attention Normalization

- 3.3. Loss Function

- 3.4. Extension for Video Style Transfer

- 4. Experiments

-

- 4.1. Implementing Details

- 4.2. Comparison with State-of-the-Art Methods

- 4.3. Ablation Study

- 4.4. Video Style Transfer

- 4.5. Multi-Style Transfer

- 5、 Conclusion

- 6、References

- A. Network Details

-

- A.1. Decoder

- A.2. AdaAttN

- B. More Results

-

- B.1. Image Style Transfe

- B.2. Video Style Transfer

Abstract

由于其在各种应用中的灵活性,任意神经风格的快速转换引起了学术界、工业界和艺术界的广泛关注。现有的解决方案要么在不考虑特征分布的情况下将深度风格特征集成到深度内容特征中,要么根据风格自适应地规范深度内容特征,以匹配其整体统计信息。虽然效果有效,留下浅层特征没有探索,没有局部考虑特征统计,但容易产生不自然的输出和不愉快的局部扭曲。为了缓解这个问题,本文提出了一个新的注意力和归一化模块,称为自适应注意力归一化(AdaAttN),在每一点的基础上自适应地实施注意力归一化。具体来说,空间注意力分数是从内容和风格图像的浅层和深层特征中学习的。然后,逐点加权统计是通过将风格特征点作为所有风格特征点的注意力加权输出的分布来计算的。最后,整合内容特征,使其显示与计算逐点加权风格特征统计相同的局部特征统计。此外,为了提高局部视觉质量,基于ADAATN推导出一种新的局部特征丢失算法。我们也扩大了AdaAttN,以便在稍作修改的情况下传输视频样式。实验表明,我们的方法实现了任何图像/视频风格的最先进传输。可使用代码和型号1。

1、Introduction

给定内容图像Ic和风格图像Is,转移艺术风格的目的是将Is应用风格模式Ic上,同时保留Ic它广泛应用于计算机辅助艺术的生成。Gatys等人[9]的开创性工作提出了一种图像优化方法,在深度神经网络特征空间中迭代和减少联合内容和风格损失。这一耗时的优化过程促使研究人员探索更有效的方法。Johnson等人[18]也考虑使用前馈网络直接生成渲染图像,实现实时风格传输。由于学习模型只能适用于特定的风格,该方法及其后续工作[40、34、35、21、27、39、16、20]分为每种风格和每种模型[17]。在文献中,每个模型的解决方案有多种风格[7、2、23、44]和[14、3、22、28、15、24、6、5、43、32、42、11]。在后一种情况下,模型可以接受任何样式图像作为输入,并在训练模型后的向前传输中产生样式化结果。因此,它是最灵活的,越来越受到学术界、工业界和艺术界的关注。

然而,随机的风格转换还远未解决。为了实现任何风格的传输网络,灵活性牺牲了当地风格模式的建模能力。例如,开拓性工作[14]提出了一种简单有效的方法AdaIN,该方法将样式图像的整体平均值和方差转换为arXiv:2108.03647v2[cs.CV]2021 支持任意输入样式图像的特征空间内容图像。由于特征的平均值和方差是全球计算的,局部细节和逐点模式在很大程度上被忽略,局部风格性能大大降低[28]。[5、22、15、24、10]灵活性和能力之间也有类似的平衡,内容图像的所有局部特征点都是基于风格图像的相同变换函数处理的。为了增强任何风格转换模型的局部意识,最近采用了许多关注[28、6、43]的机制。他们的共同直觉是,模型应该更加关注风格图像中的特征相似区域,以风格化内容图像区域。事实证明,这种注意机制有效地在任何样式转换中产生更多的局部样式细节。不幸的是,在提高性能的同时,并没有完全解决这个问题,局部失真仍然存在。

不难揭示注意机制面临上述困难的原因。对基于注意力的任何风格转换解决方案的细节进行深入研究,很容易发现:1)注意力机制的设计通常是基于更高抽象水平的深度CNN忽略低级细节的特征;2) 注意力分数通常用于重新加权样式图像的特征图,重新加权的样式特征简单地集成到内容特征中进行解码。基于深度CNN特征的注意力策略使得浅层网络层的低层图像模式未被探索。因此,注意力分数可能很少关注低层次的纹理,并受到高层次语义的支配。同时,如SANet[28](图3(b))因此,重新加权风格特征的空间,然后整合重新加权的风格特征和内容特征,其工作原理不考虑特征分布。

为此,我们试图在风格模式转换和内容结构之间取得更好的平衡。基于以上分析的经验教训,我们提出了一个新的注意力和归一化模块,称为自适应注意力归一化(AdaAttN),用于任何风格的转换。它可以在每个点的基础上自适应地进行注意力分布对齐。更详细地说,空间注意力分数是从内容和风格图像的浅层和深层特征中学习的。然后,通过将样式特征点视为所有空间特征点的注意力加权输出的分布来计算每点加权统计。最后,将内容特征归一化,使其局部特征统计与逐点加权风格统计相同。这样,注意模块考虑了风格图像和内容图像的浅层和深层CNN特征。同时,实现了从内容特征到调制风格特征的逐点特征统计对齐。基于AdaAttN该模块推导了一种新的局部特征丢失优化目标和一种新的图像传输管道。我们的贡献可以总结如下:

- 我们介绍了一种用于任何风格传输的新型AdaAttN模块。在计算注意力分数时,考虑浅层和深层特征,适当规范内容特征,使特征统计与基于各点的注意力加权平均值和方差图对齐。

- 提出了一个新的优化目标,称为局部特征损失。它有助于模型训练,并通过正则化生成图像的局部特征来提高任何风格的传输质量。

- 为了证明我们提出的方法的有效性,我们进行了大量的实验,并与其他最先进的方法进行了比较。

- 通过简单介绍基于余弦距离的注意力和图像相似性损失,进一步扩展我们的视频风格传输模型,可以获得稳定和有吸引力的结果。

2、Related Works

2.1. Arbitrary Style Transfer

最近的任何风格转换方法可分为两类:基于全局转换和局部转换。前一种共同思想是在整体范围内应用特征修改。WCT[24]这一点是通过增白和着色两个转换步骤实现的。Huang等人[14]提出AdaIN,应用每种风格特征的平均值和标准差来移动和缩放相应的综合内容特征,使内容特征和风格特征共享相同的分布。Jing等人[15]通过动态实例归一化扩展了该方法,其中间卷积块的权重由另一个以样式图像为输入的网络生成。根据内容和风格特征,李等人[22]提出线性变换。此外,邓等人[5]还获得了具有多通道相关性的函数。虽然这些方法已经完成了整个任何风格的传输任务,并在该领域取得了巨大的进展,但当地风格的传输性能通常不令人满意,因为它们很难处理详细的局部信息。

对于后者,陈等人[3]提出了一种基于补丁的风格转移方法,依赖于内容与风格补丁的相似性。[11] 同时考虑全局统计与局部面片的匹配,是另一种基于面片的方法。Avatar Net[32]结合风格交换和AdaIN功能思想。近年来,由于注意力机制能够对样式和内容图像的局部特征之间的细粒度对应进行建模,因此它被泛应用于任意样式转换。在这一过程中,Park等人[28]提出了风格注意网络(SANet),以匹配内容和风格特征。Y ao等人[43]考虑了具有这种注意力框架的不同类型的中风。邓等人[6]提出了一个多适应模块,对内容特征应用点式注意,对风格特征应用通道式注意。这些方法采用的常见做法是仅基于深度CNN特征构建注意力机制,而不考虑浅层特征,并简单地混合内容特征和重新加权的风格特征。因此,它往往会极大地扭曲原始内容结构,并对人眼产生不希望的效果。在本文中,我们的目标是探索风格模式转换和内容结构保持之间的更好权衡。0

2.2. Video Style Transfer

直接将图像样式传输技术应用于视频帧序列通常会导致由时间不一致性引起的闪烁效应。因此,许多工作将光流一致性约束添加到原始图像样式传输解决方案中,例如,[30]用于基于优化的视频样式传输,[31,1,12,13,8]用于每个样式/模型方法,[37,38]用于任意样式/模型方法,以及[36,4,26]用于图像到图像转换框架。光流约束提高了视频风格传输的稳定性。然而,它严重依赖于预提取的高精度光流场来执行基于流的扭曲。也有一些工作用光流翘曲以外的方法解决稳定性问题。[22,5]利用变换模型的线性来保证特征空间上的帧间一致性。吴等人[41]提出了一种基于SANet的方法,该方法借助SSIM一致性约束使当前帧聚焦于前一帧的相似区域。与这些方法不同的是,在本文中,我们添加了一种新的基于注意机制的图像相似性损失来克服闪烁伪影,并且在不需要先决条件光流的情况下实现了相当甚至更好的稳定性。

3、Methods

3.1. Overall Framework

该网络采用样式图像和内容图像集成电路来合成样式化图像集成电路。在我们提出的模型中,我们使用预先训练的VGG-19网络[33]作为编码器来提取多尺度特征地图。解码器遵循[14]的设置,具有对称结构的VGG19为了充分利用浅层和深层的功能,我们采用了多级策略,分别在VGG的ReLU3 1、ReLU-4 1和ReLU-5 1层上集成了三个AdaAttN模块,如图2所示。我们将VGG中ReLU-x 1层的提取特征表示为F x∗ ∈ RC×H∗W∗ 当它拍摄图像时∗ 作为输入和∗ 这里可以是c或s,分别表示内容和样式特征。为了充分利用低层模式,我们进一步将当前层的特征与其先前层的下采样特征连接为:

其中Dx表示双线性插值层,该层将输入特征降采样为相同的F x形状∗ , 和⊕ 这里表示沿通道维度的级联操作。然后,我们可以将AdaAttN模块在l层的嵌入特征表示为:

其中,Fc、Fs和Fc分别是内容、样式和嵌入特征。利用多级嵌入特征,我们可以合成带有解码器的风格化图像集成电路,如下所示:

3.2. Adaptive Attention Normalization

特征转换模块是任意样式转换模型的关键组件。图3展示了我们的模块与其他框架的比较。开创性的AdaIN[14]只考虑整体风格分布,并对内容特征进行操作,使其特征分布与风格特征的分布全局一致。通过考虑局部风格模式,SANet[28]从风格和内容特征图计算注意力图,然后用注意力图调整风格特征,将注意力输出融合到内容特征中。萨内特在当地风格化中发挥作用。然而,它缺乏低层匹配和局部特征分布对齐。受AdaIN和SAnet经验教训启发,我们提出了自适应注意力归一化(AdaAttN)模块,该模块可以通过考虑具有注意力机制的低层和高层特征,在每个点的基础上自适应地传递特征分布。如图3(c)所示,AdaAttN分三步工作:(1)计算注意力地图,从浅层到深层包含内容和风格特征;(2) 计算样式特征的加权均值和标准方差图;(3) 自适应归一化内容特征,以实现逐点特征分布对齐。

**注意力地图生成。**在任意风格转换方法中,注意力机制用于衡量内容和风格特征之间的相似性。与以往只使用较深特征的方法不同,我们同时使用内容和风格特征的低层和高层。为了计算x层的注意力图A,我们将Q(查询)、K(键)和V(值)表示为:

其中f、g和h是1×1可学习卷积层,此处的N orm表示信道平均方差归一化,如在实例归一化中使用的。注意力图A可以计算为:

⊗ 表示矩阵乘法。

**加权均值和标准方差图。**正如SANet[28]所做的那样,将注意力得分矩阵A应用于风格特征F x可以被视为通过所有风格特征点的加权总和来计算每个目标风格特征点。在本文中,我们将此过程解释为将注意力输出视为所有加权风格特征点的分布来逐个查看目标风格特征点。然后从这个角度出发,我们可以计算每个分布的统计数据。我们分别将这类统计量称为注意力加权平均值和注意力加权标准方差。因此,注意力加权平均值M∈ RC×HcWc变为:

其中A∈ RHcWc×HsWs和V∈ RC×HsWs。由于变量的方差等于其平方的期望值减去其期望值的平方,因此我们可以获得注意力加权标准差S∈ RC×HcWc组件:

其中·表示元素乘积。

自适应归一化。最后,对于归一化内容特征图的每个位置和每个通道,使用S中的相应比例和M中的偏移来生成变换后的特征图:

简而言之,AdaAttN通过生成注意力加权均值和方差图来执行特征统计传输。如图3所示,与AdaIN相比,AdaAttN考虑的是逐点统计,而不是全局统计。AdaAttN比AdaIN更一般。对于每个i,j,如果设置Ai,j=1 /(HsWs),AdaAttN可以专用于AdaIN。与SANet相比,注意力机制用于计算目标特征分布,而不是直接生成传输的特征进行进一步融合。

3.3. Loss Function

我们的总体损失函数是全局损失(Lgs)和局部特征损失(Llf)的加权总和:

其中λg和λl是控制其相应损失项权重的超参数。各损失条款的详细信息将在本节剩余部分中解释。

首先,在[14]和许多其他工作之后,对VGG特征空间中生成的图像和样式图像之间的平均µ和标准偏差σ的距离进行惩罚,以保证全局样式化效果(Lgs):

其中E()表示VGG编码器的特征,其上标x表示层索引。

提出的新型局部特征丢失Llf约束了样式化图像的特征映射与AdaAttN函数的变换结果一致:

AdaAttN在哪里∗ 用作应具有确定性的监督信号。因此,我们考虑了没有三个可学习的1×1卷积核(f、g和h)的AdaAttN的无参数版本。与[14,28]中使用的传统内容丢失项相比,局部特征丢失使模型为局部区域生成更好的样式化输出。

3.4. Extension for Video Style Transfer

与其他基于注意力的方法相比,我们的方法能够生成更自然的风格化结果,没有太多的局部失真,因此它在视频风格传输方面具有很大的潜力。只需稍作修改,我们的模型就可以扩展到视频样式传输。

首先,我们注意到,由于指数计算,等式5中的Softmax函数在注意力分数中表现出强烈的排他性,它可以主要关注局部模式,并且对稳定性有负面影响。对于视频样式传输,或者,我们考虑余弦相似性用于注意力图计算:

其中,余弦相似性导致比Softmax更平坦的注意力分数分布。因此,局部特征统计将更加稳定,局部风格模式不会被过度强调,从而更好地保证一致性。

其次,基于注意机制,我们设计了一种新的跨图像相似性损失项Lis来正则化两个内容图像c1、c2之间的相关内容:

其中,N xc是层ReLU-x 1,F x,i的内容特征图F xc中的空间维度大小∗ 表示F x第i个位置的特征向量∗ , Di,j,xu,v测量F x,iu和F x,jv的余弦距离。在每个训练迭代中,对两个输入视频帧进行采样以实现这种丢失。直观上,这种跨图像相似性损失要求两个内容图像的样式化结果与两个原始图像共享相似的局部相似模式。因此,它确保了视频样式传输中帧间关系的感知,并有助于获得稳定的结果。

4. Experiments

4.1. Implementing Details

我们使用MSCOCO[25]作为我们的内容图像集,WikiArt[29]作为我们的样式图像集来训练我们的任意样式转换模型。λg、λl和λis(用于视频样式传输仅)分别设置为10、3和100。Adam[19]的α、β1和β2分别为0.0001、0.9和0.999,用作求解器。在训练阶段,所有图像以512×512分辨率加载,并随机裁剪为256×256以进行增强。在推理过程中,我们的模型可以应用于任何分辨率的图像。在本节中,图像和视频分别使用512×512和512×256分辨率。训练在单个Nvidia Tesla P40 GPU上持续50K次迭代,批量大小为8个图像和4个视频。有关详细的网络配置,请参阅附录。

4.2. Comparison with State-of-the-Art Methods

定性比较。如图4所示,我们将我们的方法与六种最先进的任意样式传输方法进行了比较,包括AdaIN[14]、SANet[28]、MAST[5]、Linear[22]、MCCNet[5]和Avatar Net[32]。AdaIN[14]直接全局调整内容特征的二阶统计量,我们可以看到样式模式在传输时丢失了严重的内容细节(第1、第5和第6行)。Avatar Net[32]利用AdaIN进行多尺度传输,并引入了具有面片匹配策略的样式装饰器,这导致了带有明显斑块(第1、第6和第8行)的模糊样式化结果。SANet[28]和MAST[5]采用注意机制,在深层将风格特征专注地转换为内容特征。这将导致内容结构受损(第3、4和6行)和纹理变脏(第1、2和8行)。一些样式补丁甚至不正确地直接传输到内容图像中(第4行、第8行)。线性[22]和MCCNet[5]分别通过线性投影和每通道相关性修改特征,两者都产生相对干净的样式化输出。然而,样式图像的纹理模式无法自适应捕获,内容细节丢失(第3、第5和第6行),内容图像颜色保留(第7行)。如第3列所示,AdaAttN可以自适应地将样式模式适当地转移到内容图像的每个位置,这归因于每一点上新颖的注意力归一化。结果表明,AdaAttN在风格转换和内容结构保持之间实现了更好的平衡。用户研究。在SANet之后,随机选取15幅内容图像和15幅风格图像,形成总共225幅图像对。然后,我们随机抽取20个内容-风格对,用不同的方法合成风格化图像。结果以随机顺序并排呈现,我们要求受试者从三个视图中选择他们最喜欢的一个:内容保留、风格化程度和总体偏好。我们从100个用户的每个视图中收集2000张投票,并以条形图的形式显示每个方法的投票数。图6中的结果表明,我们的风格化结果比竞争对手更有吸引力。效率分析。我们在表1中演示了AdaAttN和SOTA前馈方法的运行时性能。所有实验均使用单个Nvidia P40 GPU进行。虽然使用了多深度特征层(从1 1到5 1),但我们的方法仍然可以在256px下达到20 FPS,这与SOTA方法(如SANet[28]和Linear[22])相当。因此,我们提出的ADAATN可以实际地实时合成样式化图像。

4.3. Ablation Study

损失函数。如图5所示,我们展示了消融研究结果,以验证用于训练AdaAttN的每个损失项的有效性。(1) 为了验证我们提出的局部特征丢失Llf的有效性,我们将其替换为普通L2内容丢失Lc,该Lc约束Ic和Ic之间的特征距离,并用于许多样式转换方法[14、6、28]。如第4栏所示,其视觉质量明显低于完整模型。这表明,与内容丢失相比,我们提出的局部特征丢失可以更好地考虑样式模式,同时保留内容结构。(2) 我们删除了仅使用Llf的全局损失Lgs和训练模型。如第5列所示,风格模式的传递也很弱,没有风格损失,这表明Llf可以在一定程度上迫使网络学习风格传递。然而,整体颜色饱和度降低,这表明需要全局样式损失。低电平功能。为了验证AdaAttN中使用的浅特征的有效性,我们通过将AdaAttN的Q和K从F 1:x替换为F x来移除浅特征。可以观察到一些局部内容损坏和脏纹理(图5的最后一列)。我们的AdaAttN可以有效地利用浅层特征来生成令人愉快的风格化结果。

4.4. Video Style Transfer

对于视频风格化,我们将我们的方法与SOTA方法SANet、Linear和MCCNet进行比较,其中光流不用于稳定。为了验证我们提出的视频风格化方法的有效性,我们还提供了添加Cos和Lis的消融结果,其中Cos表示余弦相似性的注意力分数(等式12)。定性结果见图7,定量结果见图9。多样式转换的结果。ble。2都证明了(1)我们的方法比基于注意力的方法SANet更稳定;(2) 用基于余弦距离的注意力代替Softmax激活可以显著提高时间一致性;(3) 通过我们提出的修改,AdaAttN比线性和MCCNet更稳定,后者是用于视频风格化的。

4.5. Multi-Style Transfer

继之前的工作[28,6]之后,我们探索了通过平均不同风格的均值和标准方差图来插值多个风格图像,然后使用组合均值和方差来调制解码的内容特征(图8)。除了样式插值外,我们还可以通过将多个样式图像连接到一个图像并将其馈送到AdaAttN中来实现多样式转换(图9)。从这些结果中,我们可以看到AdaAttN可以灵活地支持各种运行时控制,并产生合理的结果。

5、 Conclusion

在本文中,我们提出了一种用于任意样式传输的新型AdaAttN模块。AdaAttN使用样式特征的每点注意力加权均值和方差通过调制执行特征统计数据传输。注意力权重由风格和内容特征从低级到高级生成。只需稍作修改,我们的模型就可以进行视频风格的传输。实验结果表明,我们的方法可以为图像和视频生成高质量的风格化结果。AdaAttN具有改进其他图像处理或翻译任务的潜力,我们将在未来的工作中对此进行探索。

6、References

[1] Dongdong Chen, Jing Liao, Lu Y uan, Nenghai Y u, and Gang

Hua. Coherent online video style transfer. In Proceedings

of the IEEE International Conference on Computer Vision,

pages 1105–1114, 2017. 3

[2] Dongdong Chen, Lu Y uan, Jing Liao, Nenghai Y u, and Gang

Hua. Stylebank: An explicit representation for neural im-

age style transfer. In Proceedings of the IEEE conference on

computer vision and pattern recognition, pages 1897–1906,

2017. 1

[3] Tian Qi Chen and Mark Schmidt. Fast patch-based style

transfer of arbitrary style. arXiv preprint arXiv:1612.04337,

2016. 1, 2

[4] Yang Chen, Yingwei Pan, Ting Yao, Xinmei Tian, and Tao

Mei. Mocycle-gan: Unpaired video-to-video translation. In

Proceedings of the 27th ACM International Conference on

Multimedia, pages 647–655, 2019. 3

[5] Yingying Deng, Fan Tang, Weiming Dong, Haibin Huang,

Chongyang Ma, and Changsheng Xu. Arbitrary video

style transfer via multi-channel correlation. arXiv preprint

arXiv:2009.08003, 2020. 1, 2, 3, 7

[6] Yingying Deng, Fan Tang, Weiming Dong, Wen Sun, Feiyue

Huang, and Changsheng Xu. Arbitrary style transfer via

multi-adaptation network. In Proceedings of the 28th ACM

International Conference on Multimedia, pages 2719–2727,

2020. 1, 2, 3, 8

[7] Vincent Dumoulin, Jonathon Shlens, and Manjunath Kud-

lur. A learned representation for artistic style. arXiv preprint

arXiv:1610.07629, 2016. 1

[8] Chang Gao, Derun Gu, Fangjun Zhang, and Yizhou Y u.

Reconet: Real-time coherent video style transfer network.

In Asian Conference on Computer Vision, pages 637–653.

Springer, 2018. 3

[9] Leon A. Gatys, Alexander S. Ecker, and Matthias Bethge.

Image style transfer using convolutional neural networks. In

Proceedings of the IEEE Conference on Computer Vision

and Pattern Recognition (CVPR), June 2016. 1

[10] Golnaz Ghiasi, Honglak Lee, Manjunath Kudlur, Vincent

Dumoulin, and Jonathon Shlens. Exploring the structure of a

real-time, arbitrary neural artistic stylization network. arXiv

preprint arXiv:1705.06830, 2017. 2

[11] Shuyang Gu, Congliang Chen, Jing Liao, and Lu Y uan. Ar-

bitrary style transfer with deep feature reshuffle. In Proceed-

ings of the IEEE Conference on Computer Vision and Pattern

Recognition, pages 8222–8231, 2018. 1, 2

[12] Agrim Gupta, Justin Johnson, Alexandre Alahi, and Li Fei-

Fei. Characterizing and improving stability in neural style

transfer. In Proceedings of the IEEE International Confer-

ence on Computer Vision, pages 4067–4076, 2017. 3

[13] Haozhi Huang, Hao Wang, Wenhan Luo, Lin Ma, Wenhao

Jiang, Xiaolong Zhu, Zhifeng Li, and Wei Liu. Real-time

neural style transfer for videos. In Proceedings of the IEEE

Conference on Computer Vision and Pattern Recognition,

pages 783–791, 2017. 3

[14] Xun Huang and Serge Belongie. Arbitrary style transfer in

real-time with adaptive instance normalization. In Proceed-

ings of the IEEE International Conference on Computer Vi-

sion, pages 1501–1510, 2017. 1, 2, 3, 4, 5, 7, 8

[15] Y ongcheng Jing, Xiao Liu, Y ukang Ding, Xinchao Wang,

Errui Ding, Mingli Song, and Shilei Wen. Dynamic instance

normalization for arbitrary style transfer. In Proceedings of

the AAAI Conference on Artificial Intelligence, volume 34,

pages 4369–4376, 2020. 1, 2

[16] Y ongcheng Jing, Yang Liu, Yezhou Yang, Zunlei Feng,

Yizhou Y u, Dacheng Tao, and Mingli Song. Stroke con-

trollable fast style transfer with adaptive receptive fields. In

Proceedings of the European Conference on Computer Vi-

sion (ECCV), pages 238–254, 2018. 1

[17] Y ongcheng Jing, Yezhou Yang, Zunlei Feng, Jingwen Ye,

Yizhou Y u, and Mingli Song. Neural style transfer: A review.

IEEE transactions on visualization and computer graphics,

26(11):3365–3385, 2019. 1

[18] Justin Johnson, Alexandre Alahi, and Li Fei-Fei. Perceptual

losses for real-time style transfer and super-resolution. In

European conference on computer vision, pages 694–711.

Springer, 2016. 1

[19] Diederik P Kingma and Jimmy Ba. Adam: A method for

stochastic optimization. arXiv preprint arXiv:1412.6980,

2014. 7

[20] Dmytro Kotovenko, Artsiom Sanakoyeu, Sabine Lang, and

Bjorn Ommer. Content and style disentanglement for artistic

style transfer. In Proceedings of the IEEE/CVF International

Conference on Computer Vision (ICCV), October 2019. 1

[21] Chuan Li and Michael Wand. Precomputed real-time texture

synthesis with markovian generative adversarial networks. In

European conference on computer vision, pages 702–716.

Springer, 2016. 1

[22] Xueting Li, Sifei Liu, Jan Kautz, and Ming-Hsuan Yang.

Learning linear transformations for fast arbitrary style trans-

fer. arXiv preprint arXiv:1808.04537, 2018. 1, 2, 3, 7

[23] Yijun Li, Chen Fang, Jimei Yang, Zhaowen Wang, Xin Lu,

and Ming-Hsuan Yang. Diversified texture synthesis with

feed-forward networks. In Proceedings of the IEEE Con-

ference on Computer Vision and Pattern Recognition, pages

3920–3928, 2017. 1

[24] Yijun Li, Chen Fang, Jimei Yang, Zhaowen Wang, Xin Lu,

and Ming-Hsuan Yang. Universal style transfer via feature

transforms. arXiv preprint arXiv:1705.08086, 2017. 1, 2

[25] Tsung-Yi Lin, Michael Maire, Serge Belongie, James Hays,

Pietro Perona, Deva Ramanan, Piotr Dollár, and C Lawrence

Zitnick. Microsoft coco: Common objects in context. In

European conference on computer vision, pages 740–755.

Springer, 2014. 6

[26] Songhua Liu, Hao Wu, Shoutong Luo, and Zhengxing Sun.

Stable video style transfer based on partial convolution with

depth-aware supervision. In Proceedings of the 28th ACM

International Conference on Multimedia, pages 2445–2453,

2020. 3

[27] Xiao-Chang Liu, Ming-Ming Cheng, Y u-Kun Lai, and

Paul L Rosin. Depth-aware neural style transfer. In Proceed-

ings of the Symposium on Non-Photorealistic Animation and

Rendering, pages 1–10, 2017. 1

[28] Dae Y oung Park and Kwang Hee Lee. Arbitrary style

transfer with style-attentional networks. In Proceedings of

the IEEE/CVF Conference on Computer Vision and Pattern

Recognition, pages 5880–5888, 2019. 1, 2, 3, 4, 5, 7, 8, 11

[29] Fred Phillips and Brandy Mackintosh. Wiki art gallery, inc.:

A case for critical thinking. Issues in Accounting Education,

26(3):593–608, 2011. 6

[30] Manuel Ruder, Alexey Dosovitskiy, and Thomas Brox.

Artistic style transfer for videos. In German conference on

pattern recognition, pages 26–36. Springer, 2016. 3

[31] Manuel Ruder, Alexey Dosovitskiy, and Thomas Brox.

Artistic style transfer for videos and spherical images. Inter-

national Journal of Computer Vision, 126(11):1199–1219,

2018. 3

[32] Lu Sheng, Ziyi Lin, Jing Shao, and Xiaogang Wang. Avatar-

net: Multi-scale zero-shot style transfer by feature decora-

tion. In Proceedings of the IEEE Conference on Computer

Vision and Pattern Recognition, pages 8242–8250, 2018. 1,

3, 7

[33] Karen Simonyan and Andrew Zisserman. V ery deep convo-

lutional networks for large-scale image recognition. In In-

ternational Conference on Learning Representations, 2015.

3

[34] Dmitry Ulyanov, V adim Lebedev, Andrea V edaldi, and Vic-

tor S Lempitsky. Texture networks: Feed-forward synthesis

of textures and stylized images. In ICML, volume 1, page 4,

2016. 1

[35] Dmitry Ulyanov, Andrea V edaldi, and Victor Lempitsky. Im-

proved texture networks: Maximizing quality and diversity

in feed-forward stylization and texture synthesis. In Pro-

ceedings of the IEEE Conference on Computer Vision and

Pattern Recognition, pages 6924–6932, 2017. 1

[36] Ting-Chun Wang, Ming-Y u Liu, Jun-Yan Zhu, Guilin Liu,

Andrew Tao, Jan Kautz, and Bryan Catanzaro. Video-to-

video synthesis. arXiv preprint arXiv:1808.06601, 2018. 3

[37] Wenjing Wang, Jizheng Xu, Li Zhang, Y ue Wang, and Jiay-

ing Liu. Consistent video style transfer via compound reg-

ularization. In Proceedings of the AAAI Conference on Ar-

tificial Intelligence, volume 34, pages 12233–12240, 2020.

3

[38] Wenjing Wang, Shuai Yang, Jizheng Xu, and Jiaying Liu.

Consistent video style transfer via relaxation and regulariza-

tion. IEEE Trans. Image Process., 2020. 3

[39] Xin Wang, Geoffrey Oxholm, Da Zhang, and Y uan-Fang

Wang. Multimodal transfer: A hierarchical deep convolu-

tional neural network for fast artistic style transfer. In Pro-

ceedings of the IEEE Conference on Computer Vision and

Pattern Recognition, pages 5239–5247, 2017. 1

[40] Hao Wu, Zhengxing Sun, and Weihang Y uan. Direction-

aware neural style transfer. In Proceedings of the 26th ACM

international conference on Multimedia, pages 1163–1171,

2018. 1

[41] Xinxiao Wu and Jialu Chen. Preserving global and local

temporal consistency for arbitrary video style transfer. In

Proceedings of the 28th ACM International Conference on

Multimedia, pages 1791–1799, 2020. 3

[42] Zhijie Wu, Chunjin Song, Yang Zhou, Minglun Gong, and

Hui Huang. Efanet: Exchangeable feature alignment net-

work for arbitrary style transfer. In Proceedings of the

AAAI Conference on Artificial Intelligence, volume 34, pages

12305–12312, 2020. 1

[43] Y uan Yao, Jianqiang Ren, Xuansong Xie, Weidong Liu,

Y ong-Jin Liu, and Jun Wang. Attention-aware multi-stroke

style transfer. In Proceedings of the IEEE/CVF Conference

on Computer Vision and Pattern Recognition, pages 1467–

1475, 2019. 1, 2, 3

[44] Hang Zhang and Kristin Dana. Multi-style generative net-

work for real-time transfer. In Proceedings of the European

Conference on Computer Vision (ECCV) Workshops, pages

0–0, 2018. 1

A. Network Details

A.1. Decoder

我们框架的解码器将ReLU-3 1、ReLU-4 1和ReLU-5 1层上的三个AdaAttN模块的结果作为输入。与SANet的解码器类似,ReLU-5 1上的特征被上采样到与ReLU4 1相同的大小,然后进行元素相加。然后,有一个可学习的3×3卷积块用于特征变换。以下架构与VGG编码器(高达ReLU-4 1)对称,除了ReLU-3 1层上的输入通道数量是两倍,以便在此级别上合并AdaAttN输出。完整的解码器配置如表3所示。

A.2. AdaAttN

我们提供AdaAttN模块的PyTorch代码。该实现非常优雅,其整体时间和空间复杂性与SANet相同[28]。

B. More Results

B.1. Image Style Transfe

用户控制。我们的方法可以方便地支持用户控制的样式化。用户指定的内容区域将通过操作AdaAttN模块中使用的注意力图来采用用户指定的样式区域的特征。实际上,用户可以通过鼠标单击(例如,图10(左))在内容和样式图像上选择点,也可以概述具有闭合边界的区域(例如,图10(右))。然后,可以通过经典的区域增长算法生成用户指定的内容和样式图像区域。要实现使用控制的样式化,只需将指定内容区域和不感兴趣的样式区域之间的注意力分数设置为−∞ 之前,AdaAttN中的Softmax操作可以很好地工作。更多消融。正如我们在主要论文中所讨论的,有两个因素导致SANet的扭曲stlylization:缺乏底层特征和分布对齐失败。为了进一步说明这些因素的影响,我们在四种设置下进行了更多的消融研究:(1)AdaAttN,(2)没有浅特征的AdaAttN,(3)具有浅特征的SANet,和(4)SANet。如图11所示,浅特征和特征分布对齐在一定程度上防止了脏纹理。将它们结合在一起,本文中的AdaAtN以最小的失真获得了最佳的风格化结果。内容和风格的成对组合。为了证明我们的方法对不同内容和样式的鲁棒性,我们在图12中提供了8个内容图像和6个样式图像之间成对组合的样式化结果。可以看出,我们的AdaAttN能够有力地实现吸引人的风格转换结果。

B.2. Video Style Transfer

B、 2。视频风格传递定量结果。作为表2的补充,用于视频风格化的所有20种风格2的光流误差如表4所示。定性结果。我们在图13中提供了更多视频风格转换示例。完整的动画可以在附件中找到。