学习笔记24--多传感器后融合技术

时间:2022-08-22 00:00:01

本系列博客包括自动驾驶技术概述、自动驾驶汽车平台技术基础、自动驾驶汽车定位技术、自动驾驶汽车环境感知、自动驾驶汽车决策与控制、自动驾驶系统设计与应用六个栏目。作者不是自动驾驶领域的专家,只是一个探索自动驾驶道路的小白人。这个系列还没有读完,也是一边读一边总结一边思考。欢迎各位朋友,各位大牛在评论区给出建议,帮笔者这个小白挑错,谢谢!

本专栏是关于自动驾驶汽车环境感知的笔记.

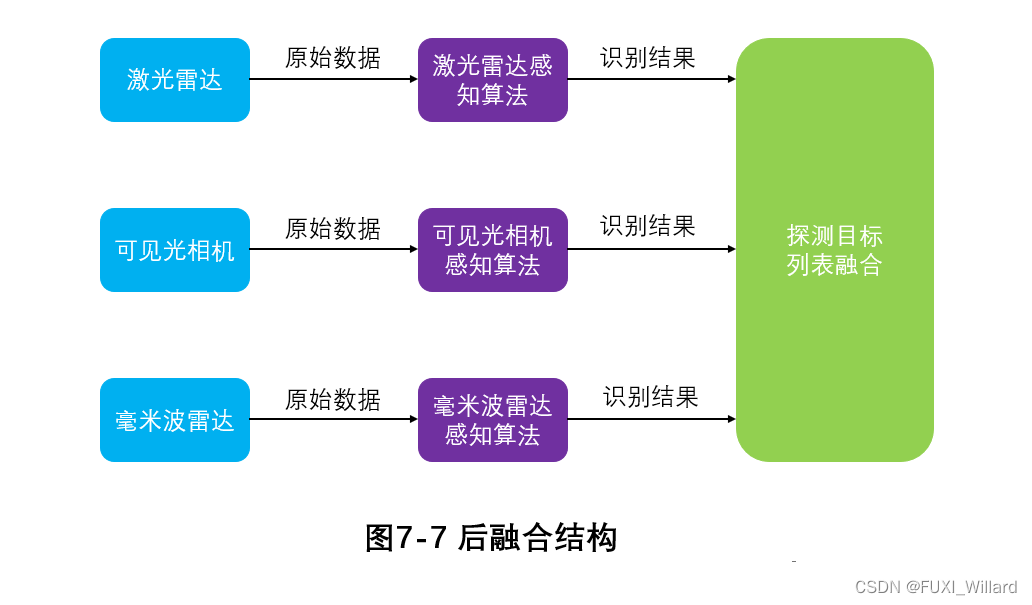

2.多传感器后融合技术

后融合技术:每个传感器独立输出探测数据信息,处理好每个传感器的数据信息后,整合总结最终感知结果。

2.1 Ulm自动驾驶:模块化集成方法

Ulm大学自动驾驶项目通过在网络映射、定位和跟踪等关键模块中使用多种传感器,提出了一种模块化、独立的传感器集成方法,允许高效的传感器更换。该算法主要集成了雷达、摄像头和激光扫描仪的探测信息IBEO LUX激光扫描仪安装在前保险杠上,摄像头安装在挡风玻璃后面,并配备多个雷达。

上图说明:

- 蓝:摄像头视野范围:;

- 红色:激光扫描仪感知范围;

- 绿色:雷达感知范围;

该算法提出了分层模块化环境感知系统(HMEP),它包括网格映射、定位和目标跟踪三个感知层;

每个感知层将传感器集成并产生环境模型结果;除传感器数据外,上层结果还可以根据环境模型元素的抽象级提高;不同的感知层结果可能是冗余至矛盾,因此组合模型将所有结果组合到统一的环境模型中。

- 网格映射层

网格映射层将周围环境分为单个网格单元,并根据经典的占用网格映射方法估计每个单元在网格图中的比例状态,输出结果为每个单元的比例概率;组合模块主要使用其输出信息来预测目标对象的边界;

具体来说:基于传感器数据,逆传感器模型可以预测每个单元概率,称为测量网格;映射算法使用二进制贝叶斯滤波器更新测量网格的网格映射,并将多传感器数据集成到网格映射层中。 - 定位层

将传感器探测数据、网格层信息和数字地图集成到定位层,输出带有自定位信息的数字地图;

具体来说:在三个激光扫描仪构建的网格图中使用极大稳定的极值区域(Maximally Stable Extremal Regions,MSER)网格图中的特征包括树干和路标;根据特征图,定位层使用蒙特卡罗定位(Monte-Carlo Localization,MCL)预测目标姿态的方法。 - 跟踪层

跟踪层集中集成雷达、摄像头和激光雷达的探测数据,感知周围环境中的移动物体。它还可以利用网格映射层和定位层的信息获取目标方向、最大速度等信息,从而完成多目标跟踪任务。

通过使用带标签的多伯努利集成模块(Labeled Muti-Bernouli,LMB)滤波器输出包含目标轨迹空间分布和存在概率的列表;使用跟踪层DempsterShafer方法实现传感器集成感知,能有效发挥各传感器的优点,避免传感器限制造成的失败; - 小结

该算法提出,未来自动驾驶感知系统的关键技术是更换传感器而不改变集成系统的核心;每个感知层提供一个通用的传感器接口,可以合并额外的传感器或替换现有的传感器,而不改变感知系统集成的核心。

提出的模块化结构有助于更换传感器,传感器独立在网络映射、定位和跟踪模块中的应用使得无需调整集成算法就可以修改传感器设置。

2.2 FOP-MOC模型

Chavez-Garcia等人提出了FOP-MOC模型将目标分类信息作为传感器集成的关键元素,以基于证据框架的方法作为传感器集成算法,重点解决传感器数据关联和传感器集成的问题。

低层融合在SLAM在模块中执行;检测层集成了各传感器检测到的目标列表;跟踪层集成了各传感器模块跟踪目标的轨迹列表,以生成最终结果。FOP-MOC传感器融合在检测层中,以提高感知系统的感知能力。

FOP-MOC模型,融合模型的输入信息有:雷达、摄像头、激光雷达的检测目标列表,输出结果为融合后的目标检测信息,并送入到跟踪模块中;雷达和激光雷达的探测数据主要用于移动目标检测,摄像头采集的图像主要用于目标分类,每个目标都由其位置、尺寸、类别假设的证据分布来表示,从形状、相对速度和视觉外观上获得类别信息。